OpenAI 终于开源了自己的模型:gpt-oss-120b 和 gpt-oss-20b,并发布了中文内容:《隆重推出 gpt-oss》。@Appinn

这是两款 Apache 2.0 许可证下的轻量级语言模型,可商用。均基于 Transformer 架构,采用专家混合(MoE)技术,gpt-oss-120b 约有 1170 亿参数,每个 token 激活约 51 亿参数;gpt-oss-20b 有 210 亿参数,激活约 36 亿参数。支持最长 128k 的上下文长度。

性能方面,gpt-oss-120b 在核心推理测试中几乎与 OpenAI 的闭源 o4-mini 模型持平,且能高效运行于单个 80GB GPU;gpt-oss-20b 性能接近 o3-mini 模型,仅需 16GB 内存,适合边缘设备和本地推理应用。

| 模型 | 层数 | 总参数 | 每个令牌的活跃参数 | 总专家数 | 每个令牌的活跃专家数 | 上下文长度 |

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

gpt-oss 使用了主要为英文的纯文本数据集对模型进行了训练,重点关注 STEM、编程和通用知识领域。并且使用了 OpenAI o4-mini 和 GPT‑4o 所用令牌化器的超集进行数据令牌化,即 ‘o200k_harmony’,该令牌化器我们今日也一并开源。

如何部署

目前 gpt-oss-120b 和 gpt-oss-20b 两个模型已经可以在 huggingface 下载:

建议个人用户尝试 20b 模型,仅需16GB显存。毕竟不是几个人有 80G 显存来部署 120b 🐶

Ollama 安装

|

1

2

3

|

# gpt-oss-20bollama pull gpt-oss:20bollama run gpt-oss:20b |

下载量大约 14GB,然后就可以使用 Ollama 对话了。

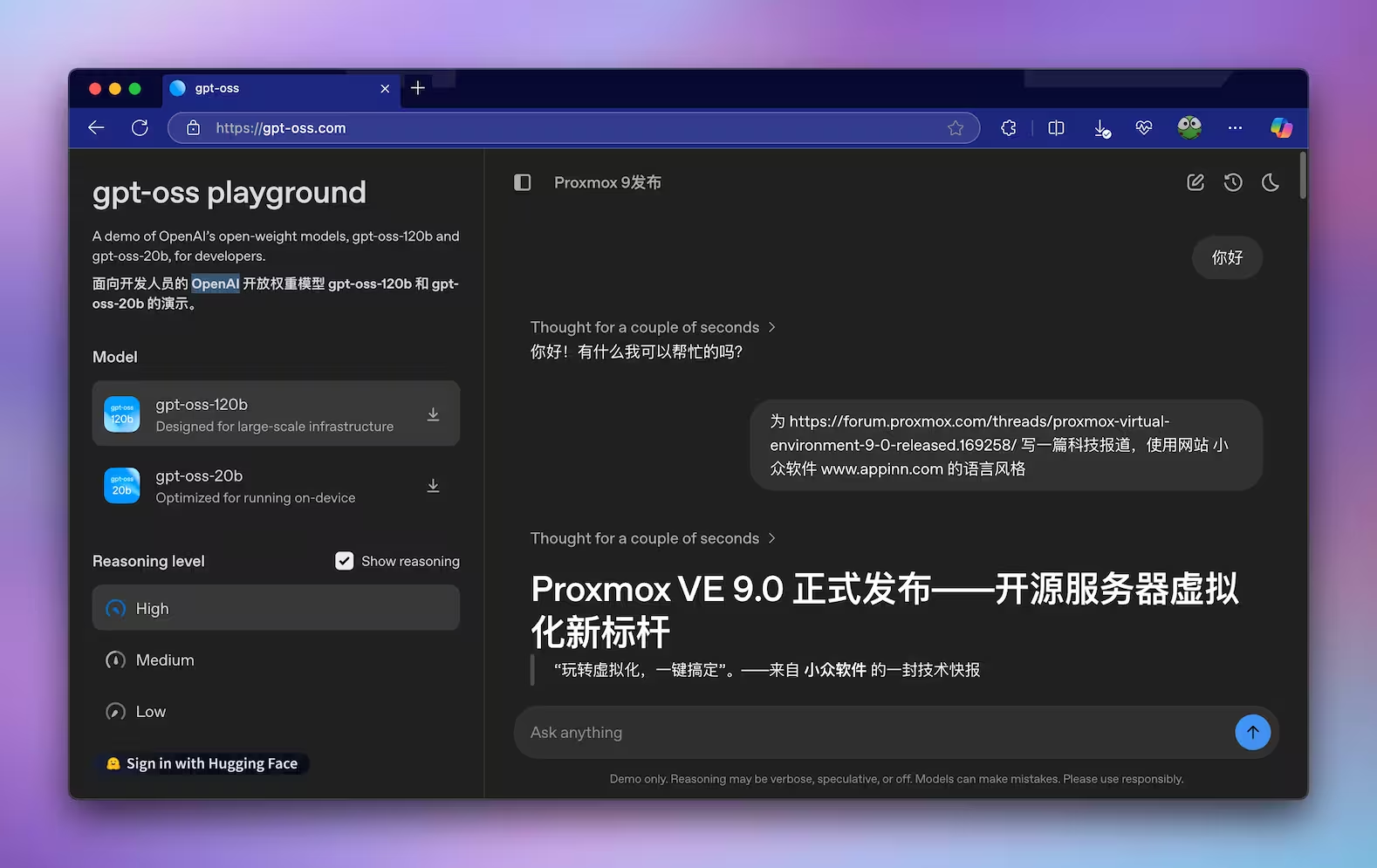

在线试用

目前可以直接在线试用这两个模型:

并且支持联网。

版权声明:1.本网站的文章部分内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长 QQ1719105222进行删除处理。

2.本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

3.本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报

4.本站资源大多存储在云盘,如发现链接失效,请联系我们我们会第一时间更新。

评论0